Code4Lib 是图书馆程序员组成的志愿者集体,从2003年秋天邮件讨论组开始,经历并保持着邮件组、聊天室、博客、各种社交网络、面对面会议(2005年开始的年会)以及编辑一份在线期刊——Code4Lib Journal。

Code4Lib Journal (ISSN 1940-5758)

本刊为季刊,2007-12-17发布第1期,今年是十周年。其宗旨是:在对图书馆、技术与未来交叉点感兴趣者中培育社区、共享信息。

2017年4月20日出版的第36期,编辑 Peter E. Murray 回顾了期刊的十年:

Editorial: Reflecting on the success and risks to the Code4Lib Journal

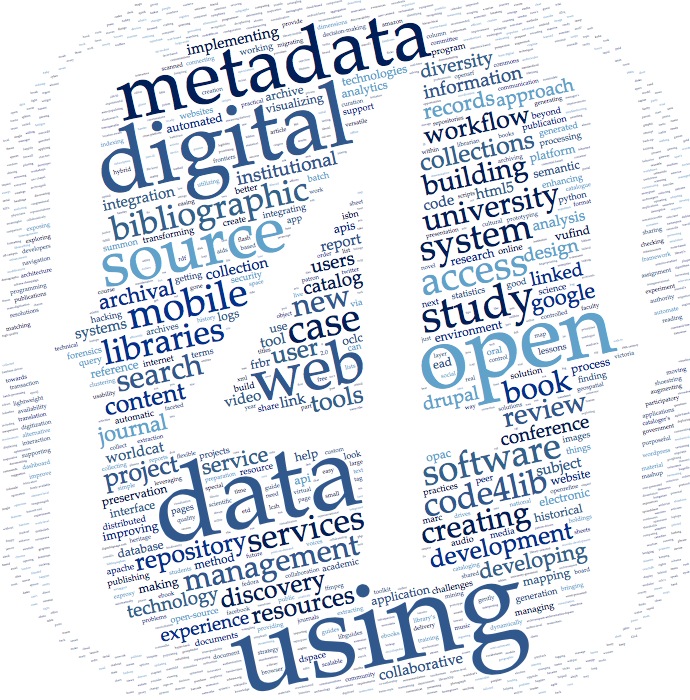

作为开放获取的在线期刊,本刊既不收版面费也不付稿费,十年累计网页浏览150万(来自中国的不少),标签云显示前35期333篇文章的关注热点:数据,数字,开放,元数据……。

该刊文章特别具有时效性,反映当前图书馆的技术热点。第36期文章概要如下:

Linked Data is People: Building a Knowledge Graph to Reshape the Library Staff Directory / Jason A. Clark and Scott W. H. Young

蒙大拿州立大学图书馆,采用 schema.org 发布员工名录,改善SEO,同时以可视化方式展示馆员的专长、学科领域及与其他馆员的关系。【可视为试手用schema.org发布关联数据】

Recommendations for the application of Schema.org to aggregated Cultural Heritage metadata to increase relevance and visibility to search engines: the case of Europeana / Richard Wallis, Antoine Isaac, Valentine Charles, and Hugo Manguinhas

建议采用 schema.org 集成 Europeana 的文化遗产元数据,以增加对搜索引擎的相关性与可见性。【第1作者Richard Wallis当年曾致力于Schema.org的图书馆扩展】

Autoload: a pipeline for expanding the holdings of an Institutional Repository enabled by ResourceSync / James Powell, Martin Klein and Herbert Van de Sompel

洛斯阿拉莫斯国家实验室的机构库LARO,只收到10%全文。通过“资源同步”(ResourceSync)标准,结合机构库Solr索引曝光元数据,自动发现未收的内容。原型 solrSync 应用,使用 Python 的 resync 库。

Outside The Box: Building a Digital Asset Management Ecosystem for Preservation and Access / Andrew Weidner, Sean Watkins, Bethany Scott, Drew Krewer, Anne Washington, Matthew Richardson

休斯顿大学图书馆,2015年承诺升级数字文化遗产馆藏的数据为开源保存与获取系统。使用关联数据词表管理器 Cedar:基于DPLA MAP(美国数字公共图书馆元数据应用纲要)的本地 SKOS 词表。

Medici 2: A Scalable Content Management System for Cultural Heritage Datasets / Constantinos Sophocleous, Luigi Marini, Ropertos Georgiou, Mohammed Elfarargy, Kenton McHenry

文化遗产数据集内容管理系统“美第奇2”:项目由NCSA、亚历山大图书馆、塞浦路斯学院合作开发,属于欧洲项目“欧洲和东地中海2 关联科学计算”,得到以下机构资助:美国国家科学基金NSF、美国档案与记录管理局NARA、美国国立卫生研究院NIH、美国国家人文基金会NEH、美国海军研究所ONR、美国环境保护署EPA及其他私营机构。【如此多公共基金资助,应当免费吧?不知道哪里可下载】

An Interactive Map for Showcasing Repository Impacts / Hui Zhang and Camden Lopez

显示机构库影响的交互地图。使用Google Analytics,近乎实时的机构库实际访问可视化,显示浏览或下载的城市,以及题名、到该页面的超链接。