万维网数据最佳实践(Data on the Web Best Practices, DWBP) 2015年2月发布为草案,而后成为W3C推荐标准。当前版本2017年1月31日:Data on the Web Best Practices, W3C Recommendation 31 January 2017.

近年使用 Web 发布的数据持续增长:世界各国政府在线共享开放数据,研究数据联盟(RDA)等组织鼓励研究数据在线发布,社交数据的收集、分析和在线发布媒体数据,信息的众包,网络上重要文化遗产收藏,以及关联开放数据云。数据发布者旨在公开或以受控访问共享数据。

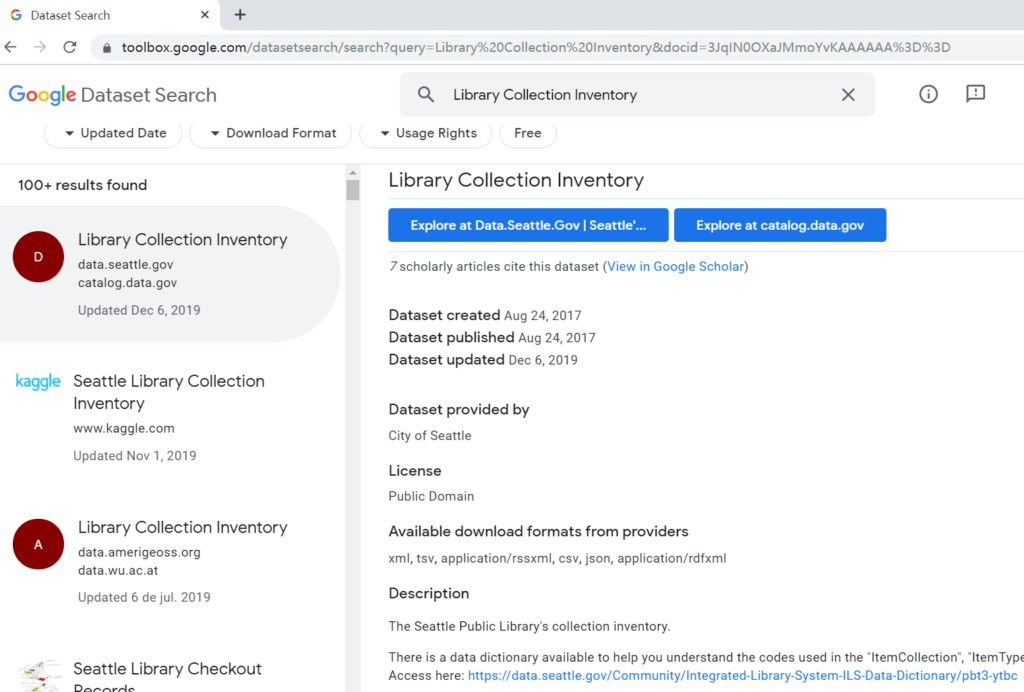

数据发布者旨在公开或以受控访问共享数据,数据消费者则希望能够找到、使用和链接到数据,这就产生了在数据发布者和数据消费者之间达成共识的基本需求。为界定 Web 上数据最佳实践的范围并引出所需的功能,DWBP 工作组编制了一组用例,代表数据通常如何在 Web 上发布以及如何在被使用,由用例派生的需求集用于指导最佳实践的开发。为鼓励数据发布者采用 DWBP,确定了8个益处:理解、可处理、可发现、重用、信任、可链接、使用权(访问/获取)和互操作,并与用例/最佳实践相关联。

虽然 DWBP 建议使用关联数据,但也鼓励其他开放格式(如 CSV)网络数据的最佳实践。

文件主要部分是第8节最佳实践的例子,内容包括:为什么,预期结果,可能的实施方法,人读、机读样例,如何测试,证据(相关需求)及益处等部分。以下是第8节最佳实践清单与第11节最佳实践益处合并处理后的表格(数字代表益处提及顺序)。

| 8.最佳实践/BP(益处) | C理解 | P可处理 | D可发现 | R重用 | T信任 | L可链接 | A访问/获取 | I互操作 |

| 8.2Metadata BP1,提供元数据(RCDP) | 2 | 4 | 3 | 1 | ||||

| BP2,提供描述元数据(RCD) | 2 | 3 | 1 | |||||

| BP3,提供结构元数据(RCP) | 2 | 3 | 1 | |||||

| 8.3Data Licenses BP4,提供数据许可证信息(RT) | 1 | 2 | ||||||

| 8.4Data Provenance BP5,提供数据出处信息(RCT) | 2 | 1 | 3 | |||||

| 8.5Data Quality BP6,提供数据质量信息(RT) | 1 | 2 | ||||||

| 8.6Data Versioning BP7,提供版本指示(RT) | 1 | 2 | ||||||

| BP8,提供版本历史(RT) | 1 | 2 | ||||||

| 8.7Data Identifiers BP9,使用永久URI作为数据集标识符(RLDI) | 3 | 1 | 2 | 4 | ||||

| BP10,使用永久URI作为数据集中的标识符(RLDI) | 3 | 1 | 2 | 4 | ||||

| BP11,为数据集版本和系列赋予永久URI(RDT) | 2 | 1 | 3 | |||||

| 8.8Data Formats BP12,使用机器可读标准化数据格式(RP) | 2 | 1 | ||||||

| BP13,使用与区域设置无关的数据表达(RC) | 2 | 1 | ||||||

| BP14,以多种格式提供数据(RP) | 2 | 1 | ||||||

| 8.9Data Vocabularies BP15,重用词表、最好是标准化的(RPCTI) | 3 | 2 | 1 | 4 | 5 | |||

| BP16,选择正确的形式化级别(RCI) | 2 | 1 | 3 | |||||

| 8.10Data Access BP17,提供批量下载(RA) | 1 | 2 | ||||||

| BP18,提供大数据集的子集(RLAP) | 4 | 1 | 2 | 3 | ||||

| BP19,使用内容协商提供多种格式的数据(RA) | 1 | 2 | ||||||

| BP20,提供实时访问(RA) | 1 | 2 | ||||||

| BP21,提供最新数据(RA) | 1 | 2 | ||||||

| BP22,为不可用的数据提供解释(RT) | 1 | 2 | ||||||

| 8.10.1Data Access APIs BP23,通过 API 提供数据(RPIA) | 2 | 1 | 4 | 3 | ||||

| BP24,使用 Web 标准作为 API 的基础(RLIDAP) | 6 | 4 | 1 | 2 | 5 | 3 | ||

| BP25,为 API 提供完整文档(RT) | 1 | 2 | ||||||

| BP26,避免对 API 进行重大更改(TI) | 1 | 2 | ||||||

| 8.11Data Preservation BP27,保留标识符(RT) | 1 | 2 | ||||||

| BP28,评估数据集覆盖范围(RT) | 1 | 2 | ||||||

| 8.12Feedback BP29,收集数据使用者的反馈(RCT) | 2 | 1 | 3 | |||||

| BP30,提供反馈渠道(RT) | 1 | 2 | ||||||

| 8.13Data Enrichment BP31,通过生成新数据来丰富数据(RCTP) | 2 | 4 | 1 | 3 | ||||

| BP32, 提供补充演示(RCAT) | 2 | 1 | 4 | 3 | ||||

| 8.14Republication BP33,向原始发布者提供反馈(RIT) | 1 | 3 | 2 | |||||

| BP34,遵守许可条款(RT) | 1 | 2 | ||||||

| BP35,引用原始出版物(RDT) | 2 | 1 | 3 |